Appearance

第6章:指令微调

指令微调是大语言模型训练过程中的关键步骤,它使得模型能够理解和执行自然语言形式的任务指令。本章将详细介绍指令微调的数据构建、训练策略、参数高效微调方法,以及代码实践与分析。

6.1 指令数据的构建

指令数据的构建是指令微调的第一步,它涉及到从不同来源收集或构建格式化的指令数据。

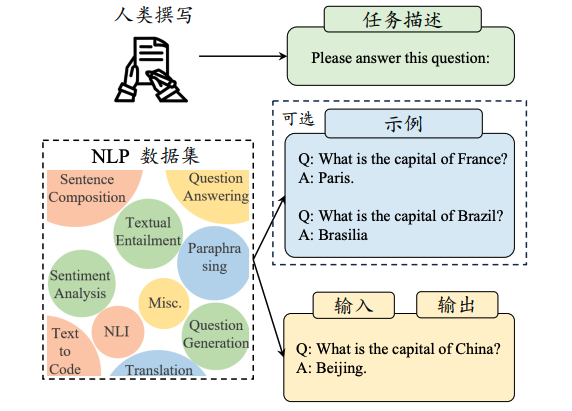

6.1.1 基于现有的NLP任务数据集构建

利用现有的NLP任务数据集,通过添加任务描述信息,将输入-输出对数据转换为指令化的数据实例。

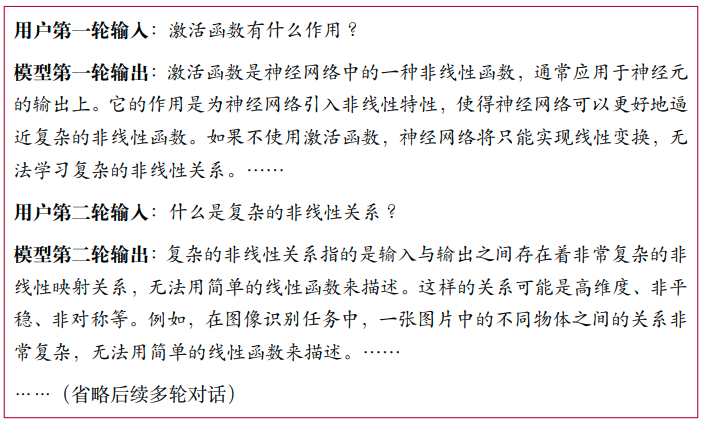

6.1.2 基于日常对话数据构建

使用用户在日常对话中的实际需求作为任务描述,结合人工标注或模型生成的回答,构建指令化的训练实例。

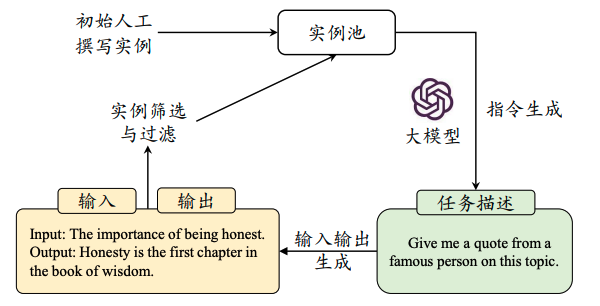

6.1.3 基于合成数据构建

通过半自动化的数据合成方法,利用大语言模型生成多样化的任务描述和输入-输出数据,以减少人工标注的成本。

6.2 指令微调的训练策略

指令微调的训练策略包括优化设置、数据组织策略等,旨在提高模型的指令遵循能力和任务性能。

6.2.1 优化设置

选择合适的优化器、学习率和批次大小,以及采用稳定的训练技巧,如权重衰减和梯度裁剪。

6.2.2 数据组织策略

包括平衡数据分布、多阶段指令数据微调和结合预训练数据与指令微调数据,以提高模型的泛化能力和稳定性。

6.3 参数高效的模型微调

参数高效的模型微调方法旨在减少微调过程中需要训练的参数量,同时保持或提升模型性能。

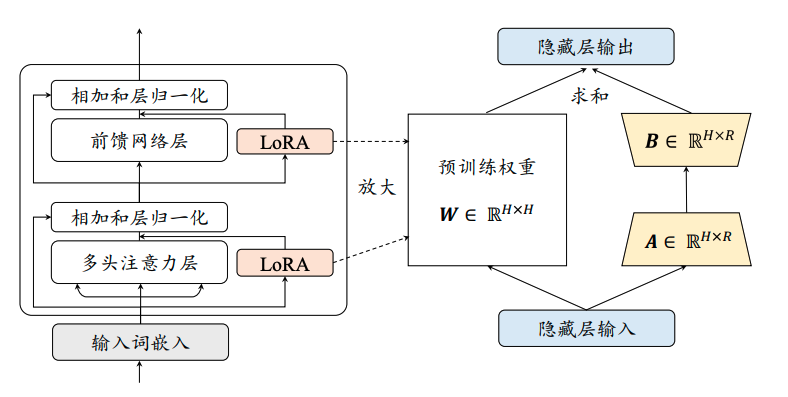

6.3.1 低秩适配微调方法

介绍LoRA微调方法,它通过在预训练模型的参数矩阵上添加低秩分解矩阵来近似参数更新,减少训练参数。

6.3.2 其他高效微调方法

包括适配器微调、前缀微调和提示微调等,这些方法通过引入少量可训练参数来实现模型的快速适配。

6.4 代码实践与分析

本节将提供指令微调和参数高效微调的代码实践,并通过实验分析不同指令数据和微调策略对模型性能的影响。

6.4.1 指令微调的代码实践

提供指令微调的代码实现,包括数据加载、模型初始化、训练循环和保存模型等步骤。

6.4.2 指令微调的实验性分析

通过实验比较不同指令数据集和微调策略对模型在特定任务上的性能影响,分析指令微调的有效性和效率。

6.4.3 LoRA代码实践与分析

提供LoRA微调的代码实现,并分析其在减少训练参数和保持模型性能方面的效果。

本章内容为读者提供了指令微调的全面指南,包括数据构建、训练策略和参数高效微调方法,以及相应的代码实践和实验分析,旨在帮助读者掌握如何通过指令微调提升大语言模型的任务性能。